Mit der Zunahme neuer, verfügbarer Technologien verändert sich auch die böswillige Nutzung von KI, was dazu führt, dass die Aktionen von Angreifern immer raffinierter werden. Ein Beispiel ist Social Engineering—die häufigste Art von Cyberangriffen. Der erfolgreiche Einsatz von Deepfakes und personalisierten Phishing-Nachrichten zeigt, wie generative KI die Qualität von Social-Engineering-Angriffen steigert. In diesem Artikel untersuchen wir die Nutzungsmöglichkeiten von KI als Angriffswerkzeug, werfen einen Blick darauf, wie sich diese mit "normaler Nutzung" überschneiden und geben Empfehlungen für den sicheren Umgang mit KI-gestützten Werkzeugen.

Einleitung

KI-gestützte Anwendungen haben eine starke Auswirkung auf Angriffsformen wie Social-Engineering und Malware. LLMs (große Sprachmodelle, Large Language Models) sorgen für eine niedrige Einstiegshürde und ermöglichen es, viel schneller anzugreifen. Es existieren zahlreiche LLM-basierte Agenten, die große Teile eines Cyberangriffs automatisieren können. Die beschleunigte Datenanalyse und Erstellung vom Code im Rahmen dieser Handlungen sorgen auch dafür, dass diese Cyberangriffe in einem viel größeren Umfang als je zuvor durchgeführt werden können, was erhebliche Herausforderungen für die Cybersecurity darstellt.

Auch Open-Source-Initiativen können es böswilligen Akteuren ermöglichen, auf frei verfügbare Technologien zuzugreifen und sie zu nutzen, um Schaden anzurichten. Dazu gehören die sogenannten Dual-Use-Güter—Werkzeuge und Apps mit mehrfachem Verwendungszweck, die sowohl für gewöhnliche als auch für kriminelle Aktivitäten eingesetzt werden können. In diesem Artikel untersuchen wir, wie sich verschiedene Verwendungen von KI als Angriffswerkzeug mit regulären Verwendungen überschneiden und geben einige Empfehlungen für den Umgang mit KI-gestützten Werkzeugen.

KI als Angriffswerkzeug: Die Auswirkung von LLMs (großer Sprachmodelle, Large Language Models)

Bei der Nutzung von LLMs in der Cybersicherheit ist die Art der Anwendung von den Absichten der Akteure abhängig. Hierbei handelt es sich oft um Dual-Use-Szenarien, da die Art der Anwendung durchaus „bösartig“ sein kann und es oft nicht besonders schwierig ist, allgemein verfügbare LLM-Werkzeuge zu missbrauchen. LLMs können die Produktivität der Cyberkriminellen steigern und eine solide Grundlage schaffen, um Erfolge im Bereich des Social Engineerings zu feiern.

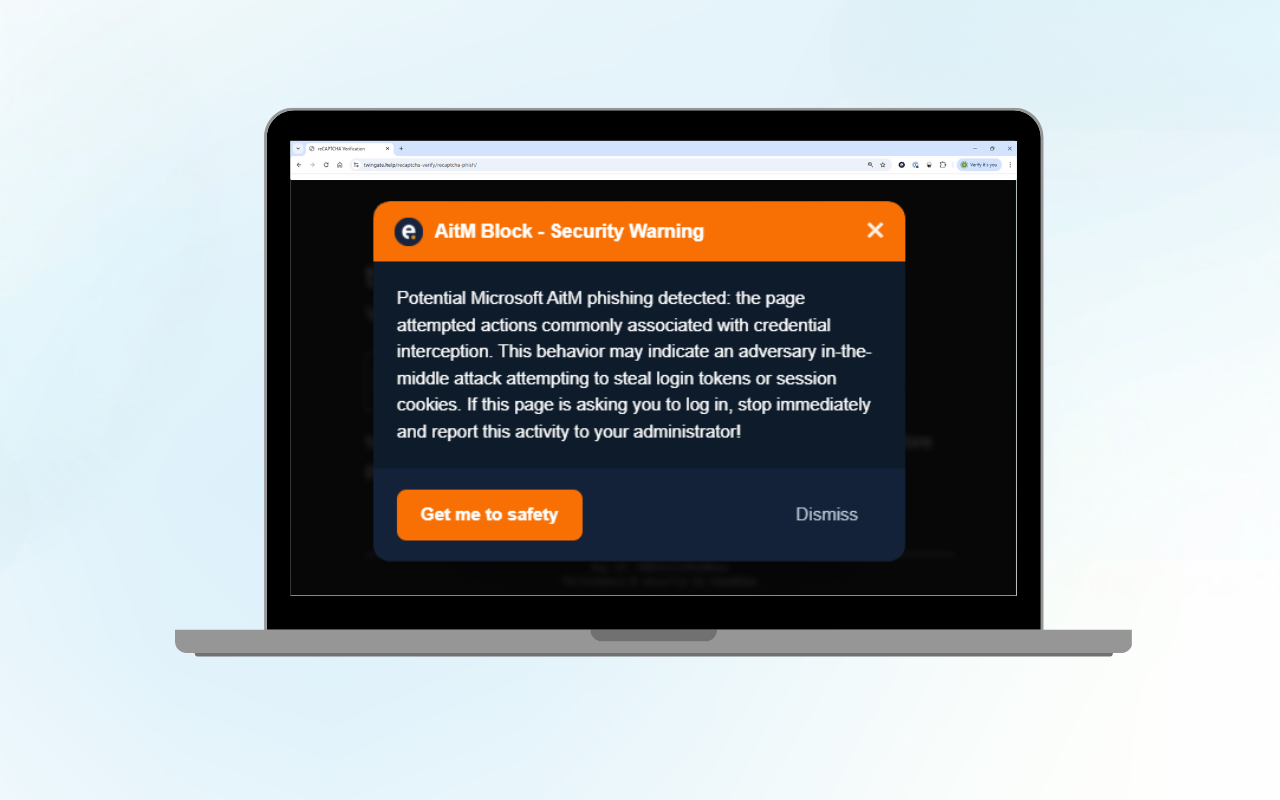

Wie kommt es dazu? Die hohe Verfügbarkeit von qualitativ hochwertigen LLMs macht es auch für Akteure mit mäßigen Fähigkeiten und geringen Sprachkenntnissen möglich, realitätsnahe Phishing-Nachrichten zu erstellen. Cyberkriminelle nutzen KI, um realitätsnahe Phishing-Nachrichten zu erstellen und die Erfolgsquote von Angriffen zu erhöhen.

LLMs machen es einfach, personalisierte Nachrichten zu generieren, einen bestimmten Schreibstil zu verwenden, die Schreibweise einer bestimmten Person nachzuahmen und sogar die Phishing-Nachrichten mit zusätzlichem, realitätsnahem Kontext zu ergänzen. Dazu kommen die sogenannten Deepfakes—mit Hilfe von KI erstellten Bilder oder Videos, die authentisch wirken.

Auch die Fähigkeit von LLM, schädlichen Code zu generieren ist relevant für den Bereich der Cybersicherheit. In ähnlicher Weise ermöglichen LLMs es Bedrohungsakteuren mit begrenztem Know-How, schädlichen Code zu generieren, der viel schneller und effizienter verteilt werden kann. Erfahrene Bedrohungsakteure hingegen sind in der Lage, ihre Operationen zu skalieren und noch größeren Schaden anzurichten. Die üblichen Open-Source-LLMs verfügen nur über einfache Filter und Funktionen, um die Aktivitäten von Bedrohungsakteuren abzuwehren. Oftmals sind diese leicht zu umgehen.

Durch den Einsatz von LLMs wird sogar der Prozess automatisiert, bei dem Cyberkriminelle ihre Unterstützung bei der Beschaffung von Kryptowährung und der Zahlung des Lösegelds nach einem Ransomware-Angriff bieten. Die Opfer von Ransomware sind oft nicht mit den Vorgaben für die Zahlung des Lösegelds vertraut, so dass die Cyberkriminellen oft Dienste in verschiedenen Sprachen anbieten, um bei dem Prozess zu „helfen“.

Weitere Entwicklungen bei KI-basierten Angriffen

Viele Cybersicherheitswerkzeuge basieren auf der automatisierten, KI-gestützten Erkennung von Sicherheitslücken, was jedoch auch neue Gefahren mit sich bringt. Dabei sind zahlreiche Open-Source-Werkzeuge entwickelt worden, die nicht nur von Unternehmen, sondern auch von Cyberkriminellen genutzt werden. Dazu werden oft offene Plattformen verwendet, um mit Malware infizierte ML-Modelle zu verbreiten. Wenn Malware in trainierten Modellen oder in Daten eingebettet ist, steigt die Gefahr, dass diese unbemerkt eingesetzt werden.

Auch Reinforcement-Learning-Systeme werden oft zu einem Werkzeug für cyberkriminelle Aktivitäten. Diese sind in der Lage, mit ihrer Umgebung zu interagieren und daraus zu lernen mit dem Ziel, langfristige Angriffsstrategien in Gang zu setzen. Der Anwendungsbereich dieser Werkzeuge könnte sehr groß sein. Beispielweise existieren KI-Werkzeuge zur Planung von Angriffsvektoren, die große Teile des Prozesses automatisieren können. Hierbei erstellt die KI eine Version eines Zielnetzes und plant die optimalen Angriffswege oder versucht, die optimalen Datenexfiltrationspfade zu identifizieren. Andere KI-Werkzeuge werden auf ein spezifisches Zielnetzwerk trainiert. So lässt sich aber der trainierte Agent nicht so einfach auf andere Netze übertragen.

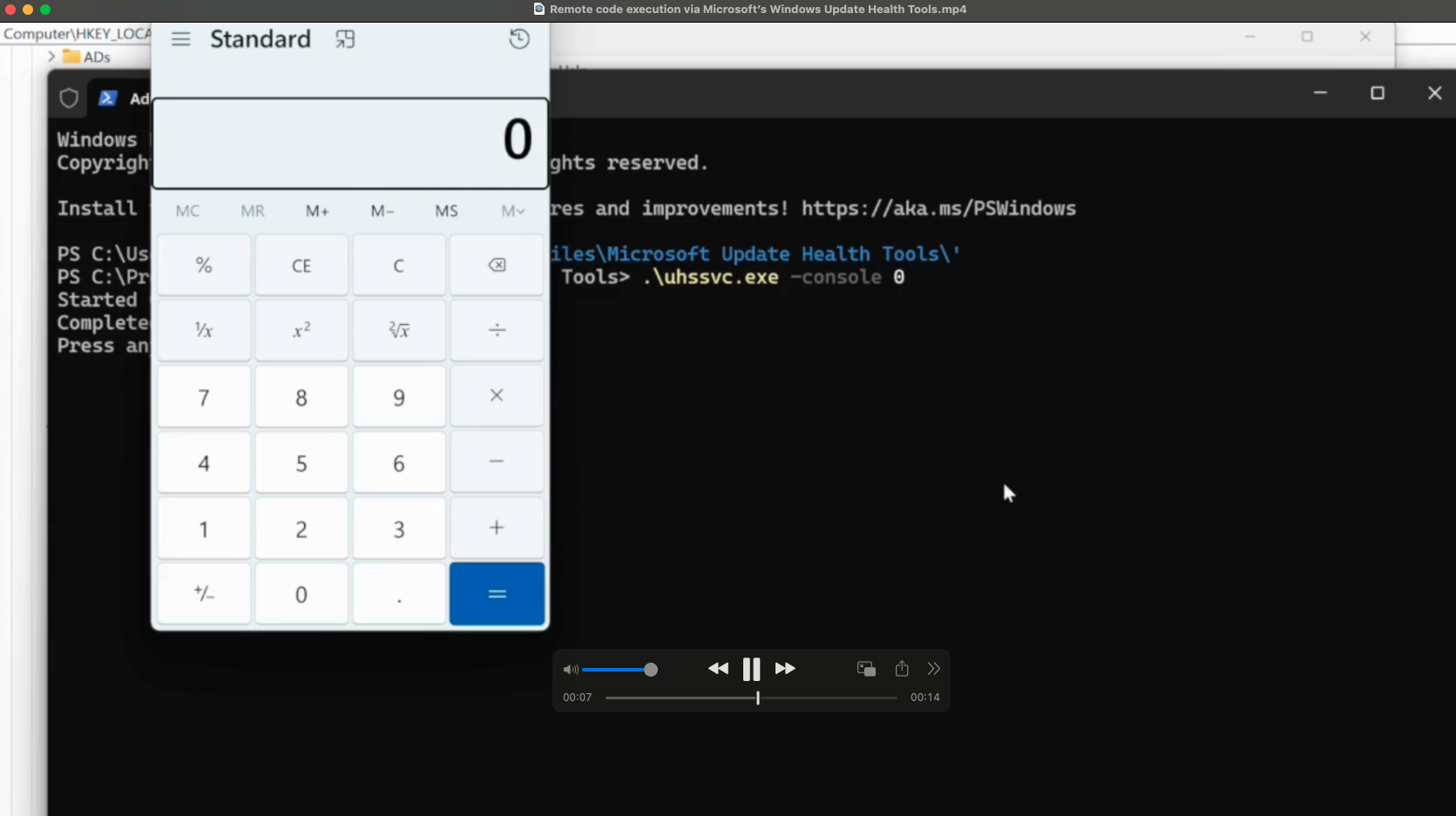

Mehrere Werkzeuge unterstützen das Penetrations-Testing (Pentesting) durch KI-Assistenten. Diese Werkzeuge sind besonders nützlich für Akteure, die versuchen, einen Cyberangriff zu starten und die Einstiegshürde durch KI zu senken. KI wird auch verwendet, um Teile der Angriffskette zu automatisieren.

Bisher ist nicht bekannt, ob der Einsatz von KI als vollautomatisiertes Angriffswerkzeug irgendwo eine Anwendung findet.

Angriffe auf Basis von KI-basierter Schadcodegenerierung

Malware, d.h. schädliche Software wie Ransomware, Trojaner oder Würmer, wird über Exploits oder Methoden des Social Engineerings auf einem Ziel-Endpunkt platziert, um Schaden anzurichten. Mit dem Einsatz von KI-gestützten Angriffswerkzeugen ist es nicht mehr ausreichend, in diesem Bereich reine klassische Maßnahmen wie Virenscanner einzusetzen. KI-Modelle—von LLMs über GANs (Generative Adversarial Networks) bis hin zu Reinforcement-Learning-Systemen—werden auf den Bereich für verschiedene Zwecke eingesetzt, auch von technisch wenig versierten Akteuren.

Mithilfe von natürlicher Sprache können einfache Schadprogramme erstellt werden. Jedoch gibt es derzeit keine KI, die eigenständig komplexe Malware mit fortschrittlichen Verschleierungstechniken oder Zero-Day-Exploits entwickeln kann, da die notwendigen Trainingsdaten teuer und schwer zugänglich sind.

Zweitens kann KI existierende Malware modifizieren, um sie schwerer erkennbar zu machen. Dieser Ansatz erfolgt meist im Featureraum und nicht auf Codeebene. Obwohl es bereits Proof-of-Concept-Werkzeuge gibt, bleibt dies bislang auf den akademischen Bereich beschränkt und erfordert eine hohe Expertise sowie umfangreiche Datenressourcen.

Schließlich kann KI in die Funktionalität von Malware integriert werden, etwa durch polymorphe Engines, die den Schadcode dynamisch verändern, um Erkennungen zu umgehen. Denkbar ist auch, dass KI-Modelle so trainiert werden, dass sie das Verhalten von Nutzern nachahmen, um die Aktionen von Malware weniger auffällig zu machen. Derzeit existieren jedoch keine Hinweise auf praktische Anwendungen, auch wenn theoretische Szenarien häufig diskutiert werden. Die Arbeit an der Entwicklung sicherer Algorithmen und Protokolle ist jedoch unerlässlich, um neue Bedrohungen abzuwehren.

Lösungen und Strategien

Um den Herausforderungen der KI-basierten Bedrohungen zu begegnen, müssen Unternehmen umfassende Sicherheitsstrategien entwickeln und umsetzen. Dazu gehört der Einsatz von fortschrittlichen Sicherheitslösungen wie Multi-Faktor-Authentifizierung, regelmäßige Sicherheitsüberprüfungen und die Implementierung von KI-gestützten Erkennungssystemen. Darüber hinaus sollten Unternehmen in die kontinuierliche Weiterbildung ihrer Mitarbeitenden investieren, um das Bewusstsein für Cyberbedrohungen zu schärfen und die Reaktionsfähigkeit zu verbessern. Eine enge Zusammenarbeit mit Cybersicherheitsanbietern und die Nutzung von Managed Security Services können ebenfalls dazu beitragen, die IT-Sicherheit zu stärken und auf dem neuesten Stand zu halten.

Entwickler von KI-Systemen spielen eine zentrale Rolle bei der Sicherstellung der IT-Sicherheit. Es ist wichtig, dass sie sichere Algorithmen und Protokolle verwenden und Sicherheitsfunktionen in ihre Systeme integrieren. Regelmäßige Überprüfungen und Aktualisierungen der Systeme sind unerlässlich, um neue Bedrohungen abzuwehren. Entwickler sollten sich kontinuierlich über die neuesten Bedrohungen und Angriffsmethoden informieren und ihre Systeme entsprechend anpassen. Durch die Einhaltung dieser Richtlinien und Strategien können Entwickler dazu beitragen, die Sicherheit von KI-Systemen zu gewährleisten und die Risiken für Unternehmen zu minimieren.

Fazit und Ausblick

Die Nutzung von KI-gestützten Anwendungen macht es möglich, Cyberangriffe zu verstärken, diese viel schneller durchzuführen, und deutlich raffiniertere Methoden des Social Engineerings einzusetzen. Um mit der sich rasant entwickelnden Bedrohungslandschaft Schritt halten zu können, sollten Unternehmen Cybersicherheit die höchste Priorität einräumen und die Chance nutzen, durch den Einsatz von KI-gestützten Werkzeugen ihre Verteidigungsstrategien zu verbessern. Häufig sind die Maßnahmen der klassischen Cybersicherheit nicht mehr ausreichend, um einen wirksamen Schutz gewährleisten zu können.

Der Einsatz von KI-gestützten Werkzeugen geht über die klassischen Cyberangriffe hinaus—daher ist es umso wichtiger, auch die Geschwindigkeit und den Umfang der Abwehraktivitäten zu steigern. Dazu gehören sowohl strategische Schritte wie der Aufbau einer zeitgemäßen IT-Infrastruktur, der Einsatz eines 24/7 Security Operations Centre (SOC) und die Durchführung von Schulungen zur Stärkung der Prävention von Social-Engineering-Angriffen als auch taktische Maßnahmen wie die Einführung von Multi-Faktor-Authentifizierung und Maßnahmen zur Verbesserung des Patchmanagements. Mehr dazu erfahren Sie in unserem Artikel „Cybersicherheit im Unternehmen: Wie sich KMU noch heute schützen können“.

Und nicht zuletzt sollten Unternehmen die Vorteile von KI als Verteidigungswerkzeug in Sinne der Bedrohungserkennung und des Schwachstellenmanagements nutzen. Als MXDR-Anbieter stellt Eye Security eine MDR-Lösung zur Verfügung, die Werkzeuge zum Extended Detection and Response (XDR), Attack Surface Management (ASM), Threat Hunting und Anti-Spoofing mit einem 24/7 Incident Response-Service (SOC) kombiniert. Mehr dazu finden Sie auf unserer Seite zum Thema Managed Extended Detection and Response (MXDR).