Der Einsatz von künstlicher Intelligenz (KI), insbesondere des maschinellen Lernens (ML), eröffnet enorme Innovationsmöglichkeiten. Um das Potenzial von KI-Systemen für die Cybersicherheit erschließen zu können, werden jedoch wirksame Qualitätsmanagementverfahren für Unternehmen benötigt. Die Best Practice-Empfehlungen zum verantwortungsvollen Umgang mit Algorithmen und Daten sollten von einer datenschutzfreundlichen Gestaltung der IT-Systeme und einer starken IT-Sicherheit begleitet werden. Mit den zahlreichen ungeklärten rechtlichen Fragen in diesem Zusammenhang sollte offen und strukturiert umgegangen werden.

KI-Systeme bringen eine Reihe von rechtlichen und regulatorischen Risiken mit sich. Da nicht alle Methoden zur Validierung der Genauigkeit und Leistung von KI-Systemen zuverlässig sind, müssen die Unternehmen die regulatorischen und operativen Risiken, die mit diesen Systemen verbunden sind, genauer betrachten.

Definitionen und Grundlagen

Was verstehen wir unter Künstliche Intelligenz und KI-Systemen?

Künstliche Intelligenz (KI) bezieht sich auf die Entwicklung von Computersystemen, die Aufgaben ausführen und Entscheidungen treffen können, die normalerweise menschliche Intelligenz erfordern. Diese Systeme sind in der Lage, aus Erfahrungen zu lernen, Muster zu erkennen und Probleme zu lösen, ohne explizit programmiert zu sein. KI-Systeme sind Software- und Hardwaresysteme, die Künstliche Intelligenz nutzen, um in der physischen oder digitalen Welt „rational“ zu handeln. Sie können in verschiedenen Bereichen eingesetzt werden, von der Automatisierung von Geschäftsprozessen bis hin zur Verbesserung der Cybersicherheit. Die Bedeutung von KI-Systemen wächst stetig, da sie Unternehmen helfen, effizienter und sicherer zu arbeiten.

Maschinelles Lernen und Deep Learning

Maschinelles Lernen (ML) ist ein häufig verwendeter Teilbereich der KI. ML-Algorithmen und -Techniken ermöglichen es Systemen, aus Daten zu lernen und Entscheidungen zu treffen, ohne explizit programmiert zu sein. Dies geschieht durch die Analyse großer Datenmengen und die Identifizierung von Mustern, die dann zur Verbesserung der Systemleistung genutzt werden. Deep Learning (DL) ist eine spezialisierte Teilmenge des maschinellen Lernens, die künstliche Rechenmodelle nutzt, die von menschlichen Gehirnen inspiriert sind und als neuronale Netze bezeichnet werden. Diese Netze sind in der Lage, komplexe Aufgaben wie Bilderkennung, Sprachverarbeitung und sogar autonome Entscheidungsfindung zu bewältigen. Durch die Anwendung von Deep Learning können Unternehmen tiefere Einblicke in ihre Daten gewinnen und fortschrittlichere Lösungen entwickeln.

KI, Cybersicherheit und Datenschutz: Eine umstrittene Konstellation

Die Anforderungen an Datenschutz und „Explainability“ (Erklärbarkeit) stellen für einige KI-Anwender eine echte Herausforderung dar: Die wachsende Komplexität des maschinellen Lernens und die zunehmende Beliebtheit von Deep-Learning-Algorithmen, die sich wie „Black Boxes“ verhalten, führt dazu, dass oft hochpräzise Ergebnisse erzielt werden, ohne erläutern zu können, wie diese Ergebnisse ermittelt wurden.

Die Vorteile bleiben jedoch enorm. Bei dem Einsatz von KI zum Schutz von IT-Systemen können Sicherheitsexperten große Datenmengen verarbeiten, sicherheitsrelevante Events verschiedener Komplexitätsstufen identifizieren und auswerten, sowie gleichzeitig den Überblick über den Status der Systeme behalten und auf Cyberangriffe reagieren.

Laut einer Studie von IBM (Total Cost of Data Breach Report 2024) sparen Unternehmen, die KI in ihrer Cybersicherheit einsetzen, durchschnittlich 3,05 Millionen US-Dollar (aktuell 2,83 Millionen Euro) und 74 Arbeitstage bei der Beseitigung von Sicherheitsverstößen.

Welche Anwendung findet KI in die Cybersicherheit?

Nachfolgend finden Sie eine Übersicht über die häufigsten Anwendungen von KI zum Schutz kritischer Systeme in Unternehmen vor Cyberangriffen:

Intrusion Detection (and Prevention)-Systeme

In einem Intrusion Detection and Prevention-System (IDPS) kann ein KI-System genutzt werden, um Angreifer zu erkennen und vordefinierte Schutzmaßnahmen auszulösen, wie das Blockieren von IP-Adressen oder das Isolieren der bedrohten Systeme.

Intrusion Detektion-Systeme (IDS) sind in der Lage, Cyber-Angriffe selbstständig zu erkennen oder das Erkennen zu erleichtern. Bei der Anwendung von überwachten Machine Learning-Algorithmen werden Daten von Angriffen als Trainingsdaten verwendet, um ähnliche Ereignisse zu erkennen. Überwachtes ML kann jedoch neue Angriffsformen nicht so gut nachvollziehen. Bei der unüberwachten „Anomalie-Detektion“ werden Aktivitäten oder Verhaltensweisen erkannt, die stark von der Norm abweichen. Hier werden aber oft „False Positives“ erzeugt.

Incident Response-Automatisierung

Automatisierung kann auch in der Bedrohungsabwehr eingesetzt werden, beispielsweise mit Incident Response-Automatisierung: KI-gestützte Systeme erkennen Bedrohungen und reagieren mit einem vorgegebenen Playbook auf Sicherheitsvorfälle. Risiken können so minimiert und Reaktionen beschleunigt werden. Incident Response Automation umfasst das Erkennen des Angriffs, die Isolierung des feindlichen Systems, das Blockieren und eine anschließende Wiederherstellung mittels Backups. Es ist wichtig, dass KI-Systeme regelmäßig überprüft werden, um ihre Effizienz und Sicherheit zu gewährleisten.

Security Information and Event Management (SIEM)

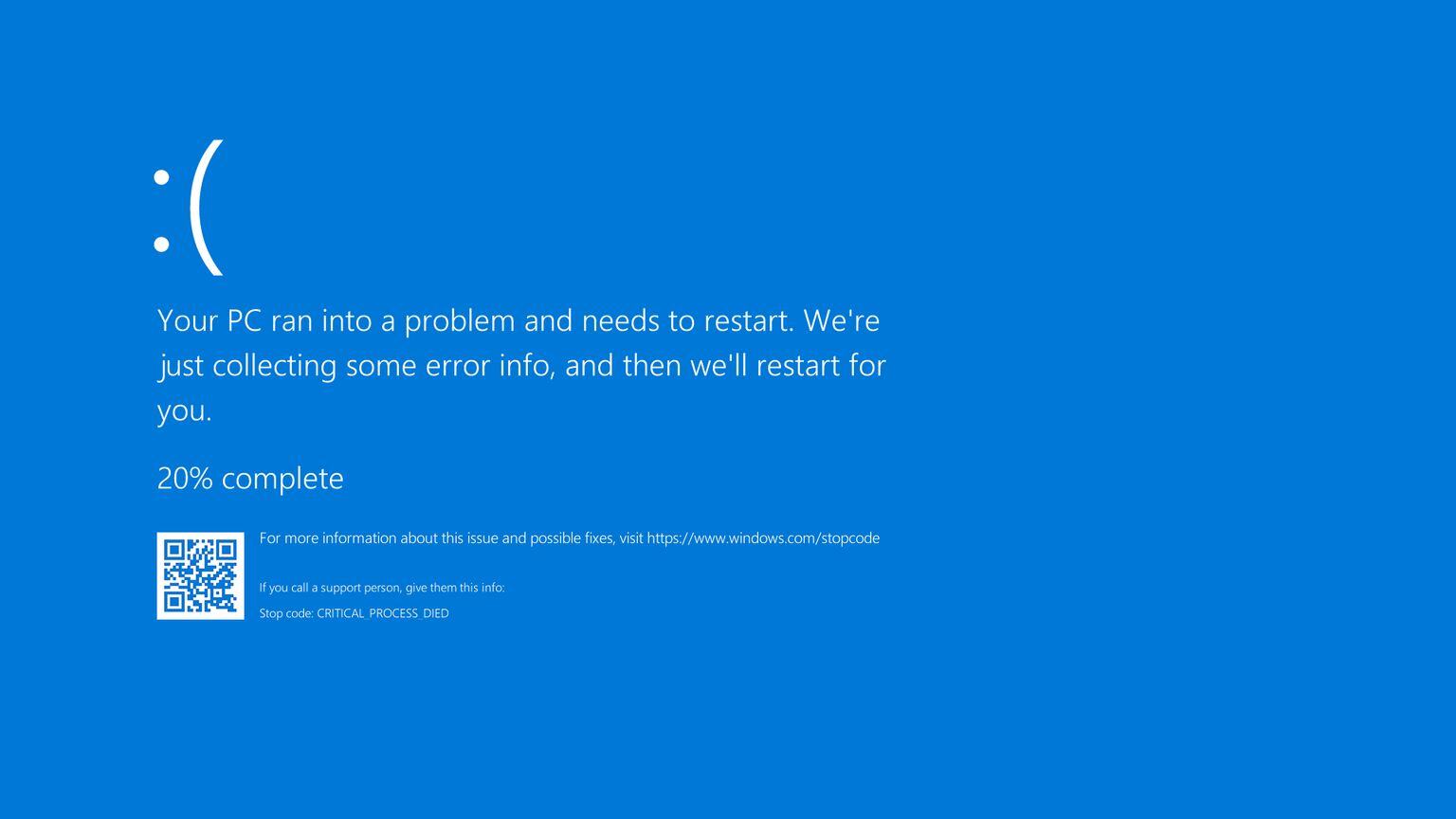

SIEM-Lösungen aggregieren umfassende Informationen über die Systeme, die sie überwachen, um Vorfälle in Echtzeit zu entdecken und zu bearbeiten. KI ermöglicht es, sowohl auf strukturierte Daten wie Logdaten zuzugreifen als auch unstrukturierte Daten zu berücksichtigen. Dies beinhaltet zum Beispiel Absturzmeldungen von Apps, E-Mail-Hinweise von Mitarbeitern oder generierte Bilder zur Visualisierung von Bedrohungen.

Vorausschauende Analyse

Mit der Analyse von Datensätzen und der Erkennung von Mustern lassen sich auch zukünftige Bedrohungen vorhersagen. Dabei gelten als Datenquelle nicht nur Cyberattacken, mit denen das Unternehmen in der Vergangenheit schon konfrontiert war. Mit der sogenannten Threat Intelligence sammeln KI-Systeme Daten aus Quellen wie Sicherheitsprotokollen, dem Dark Web oder Bedrohungsdatenbanken, um Angriffe zu analysieren und Sicherheitsmaßnahmen anzupassen.

Vorfälle können zunehmend anhand von Daten aus aktuellen Angriffskampagnen oder dem Überwachen von Foren ermittelt werden. Dabei wird Natural Language Processing (NLP) eingesetzt, um Risiken in der Kommunikation zwischen potenziellen Angreifern zu erkennen.

Ohne KI und Automatisierung ist es nahezu unmöglich, Cyber-Risiken zu bewältigen. Gleichzeitig erfordert der Einsatz von KI im Cybersecurity-Bereich eine solide Qualitätsmanagementstrategie.

Risiken von KI in der Cybersicherheit

KI-Systeme können auch von Angreifern manipuliert werden, um falsche Ergebnisse zu liefern. Dies kann zu einer Vielzahl von Problemen führen, einschließlich der Verletzung von Datenschutzgesetzen und der Beeinträchtigung der Sicherheit von Systemen und Anwendungen. Beispielsweise könnten Angreifer KI-Modelle so verändern, dass sie legitime Bedrohungen nicht erkennen oder harmlose Aktivitäten als gefährlich einstufen.

Es ist wichtig, dass Unternehmen und Organisationen ihre KI-Systeme regelmäßig überprüfen und aktualisieren, um sicherzustellen, dass sie sicher und zuverlässig sind. Dies kann durch die Implementierung von Sicherheitsmaßnahmen wie Firewalls, Antivirus-Software und regelmäßigen Sicherheitsaudits erreicht werden. Darüber hinaus sollten Unternehmen und Organisationen ihre Mitarbeiter über die Risiken von KI-Systemen aufklären und sie dazu anhalten, vorsichtig zu sein, wenn sie mit KI-Systemen arbeiten. Dies kann durch die Bereitstellung von Schulungen und Richtlinien erreicht werden, die die sichere Nutzung von KI-Systemen fördern.

Insgesamt ist es wichtig, dass Unternehmen und Organisationen sich der Risiken von KI-Systemen bewusst sind und entsprechende Maßnahmen ergreifen, um ihre Cybersicherheit zu verbessern. Durch die Implementierung von Sicherheitsmaßnahmen und die Aufklärung von Mitarbeitern können Unternehmen und Organisationen die Risiken von KI-Systemen minimieren und ihre Cybersicherheit verbessern.

Welche Kriterien und Maßnahmen zum KI-Qualitätsmanagement im Unternehmen sind zu empfehlen?

Im Folgenden skizzieren wir einige der Kriterien und Umsetzungsmaßnahmen, die erstmals in dem Empfehlungspapier „Eberbacher Gespräche über KI, Sicherheit und Privatheit“ des Frauenhofer-Instituts für Sichere Informationstechnologie dargelegt worden sind.

Mindestqualitätsstandard von KI für die Cybersicherheit

Bei ML-Systemen können die Leistungen der Angriffserkennung unter Laborbedingungen erheblich von der Leistung in realen Umgebungen abweichen. Oft lässt sich auch nicht genau sagen, auf welcher Grundlage entsprechende Ergebnisse erzielt werden. Zur Beurteilung benötigen Unternehmen die s.g. False Acceptance und False Positives sowie genauere Angaben zu den verwendeten Trainingsdaten. Maßgeblich ist die Verifizierbarkeit der Entscheidungen.

Rechtssichere Verfahren der Datenanonymisierung in KI-Systemen

Sobald Rohdaten in ein Modell eingegeben wurden, gibt es keine einfache Möglichkeit, sie zu entfernen, es sei denn, das Modell wird neu erstellt, was unpraktikabel und teuer ist. Daher ist es empfehlenswert, datenschutzfreundliche Mechanismen zu entwickeln, um die Integrität der Daten noch vor der Auswertung zu gewährleisten.

Datenschutz und Big Data sind nicht unvereinbar. Jedoch stellen Big Data und KI eine Herausforderung für die Wirksamkeit des Datenschutzes dar. Durch die Analysen entstehen oft Verknüpfungen zwischen Daten, die die angestrebte Datenanonymität aufheben. Bei trainierten neuronalen Netzen ist es auch möglich, die Trainingsdaten zu rekonstruieren und Bezüge zu Personen herzustellen. Wie der Datenschutz beim Einsatz von KI-Techniken nachweislich eingehalten werden kann, ist teilweise unklar.

An dieser Stelle ist es ratsam, Best Practice-Empfehlungen zu entwickeln, die festlegen, welche Schutzmaßnahmen nach dem Stand der Technik zu verwenden sind, um personenbezogene Daten vor der Auswertung zu pseudonymisieren oder zu anonymisieren.

Klare Haftungsregelungen

Unklare Haftungsregelungen bremsen Unternehmen dabei, das volle AI-Potenzial zur Erhöhung der Cybersicherheit zu erschließen. Wenn das Haftungsrisiko nicht abgeschätzt werden kann, können Unternehmen auf einen ansonsten plausiblen Einsatz verzichten.

Nach der Verabschiedung des Gesetzesvorschlags über künstliche Intelligenz (AI-Act) hat die Europäische Kommission den Richtlinienentwurf über KI-Haftung veröffentlicht. Dieser soll einen harmonisierten Rechtsrahmen schaffen und die bei KI-Systemen verursachten Haftungslücken füllen.

Erstellung eines „Code of Conduct“ für den sicheren Umgang mit KI

Ansätze für ein Regelwerk sind bereits vorhanden, zum Beispiel die Hambacher Erklärung und die Empfehlungen der Datenethik-Kommission beim Bundesinnenministerium des Innern und für Heimat. Ein Code of Conduct für den sicheren Umgang mit KI könnte darauf basieren und sollte überprüfbar und verifizierbar sein, d.h. die Data-Journeys von der Erhebung bis hin zur Speicherung und Verarbeitung sollten nachvollziehbar und valide sein.

Etablierung von Risikomanagement-Maßnahmen

Weitere Herausforderungen stellen die unterschiedlichen Aggressoren dar, die selbst KI-Methoden als Angriffswerkzeuge verwenden, einschließlich Social Engineering Angriffe. Diese können Wirtschaftskriminellen oder staatliche Angreifer, die kritischen Infrastrukturen anvisieren. In dieser Hinsicht sind Strategien zum Risikomanagement erforderlich. Dazu gehören die Priorisierung von Aggressoren und die Schaffung von Prioritätsstufen für Lokalitäten, die Gegenstand eines Angriffs werden können.

Hierzu empfiehlt Gartner die Verwendung des AI TRiSM Framework: Risikomanagement mit KI-Vertrauens-, Risiko- und Sicherheitsmanagement (AI TRiSM). Es handelt sich um ein Regelwerk von Kontrollen und vertrauensbildenden Maßnahmen, die eine kontinuierliche Überwachung ermöglichen: 1) Erkennung von Anomalien bei Inhalten, 2) Data Governance und Schutz, 3) Verringerung der Sicherheitsrisiken von Anwendungen.

Gartner prognostiziert, dass Unternehmen, die TRiSM-Kontrollen auf KI-Anwendungen einsetzen, bis 2026 mindestens 50 % weniger ungenaue oder unzulässige Informationen nutzen werden, die zu fehlerhaften Entscheidungen beitragen können.

Fazit und Ausblick

Unternehmen profitieren von KI-gestützten Systemen, die Bedrohungen schneller erkennen, Angriffe abwehren und zukünftige Risiken prognostizieren können. Gleichzeitig sind jedoch Herausforderungen wie mangelnde Erklärbarkeit, Datenschutzbedenken und unklare Haftungsregelungen ernst zu nehmen.

Für Unternehmen ist es entscheidend, Qualitätsstandards für KI-Systeme zu etablieren und datenschutzfreundliche Mechanismen wie Datenanonymisierung frühzeitig umzusetzen. Mit einem durchdachten Qualitäts- und Risikomanagement kann KI nicht nur Sicherheitsrisiken minimieren, sondern auch als strategisches Werkzeug zur Sicherung eines Wettbewerbsvorteils dienen.